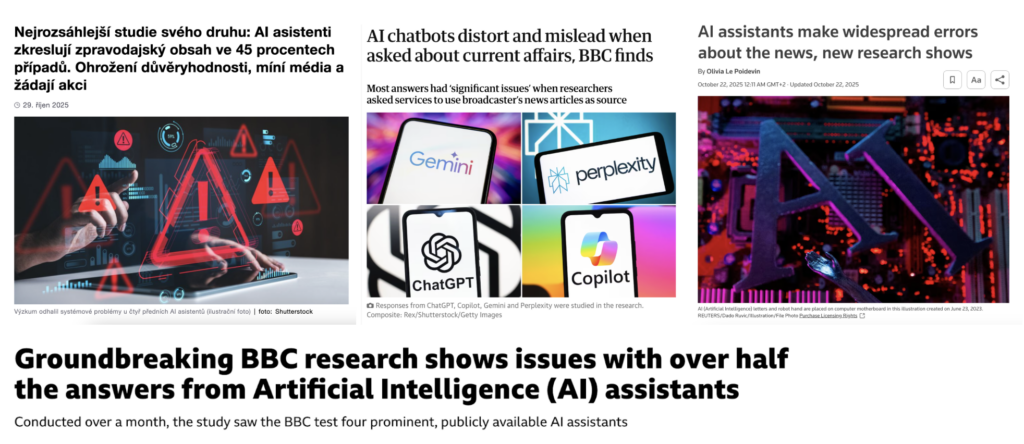

Evropská vysílací unie (EBU) ve spolupráci s BBC nedávno zveřejnila rozsáhlý test toho, jak umělá inteligence odpovídá na běžné zpravodajské dotazy. Výsledek je skoro alarmující: 45 % odpovědí AI chatbotů obsahovala zásadní chyby. Nepřesné informace, smyšlené citace či chybně interpretované události. Na první pohled to může vypadat jako drtivý důkaz, že AI je nespolehlivá a zpravodajství od ní brzy očekávat nemůžeme. Jenže při bližším pohledu se ukazuje, že studie sice odhaluje reálný problém, ale zároveň nechtěně vytváří zavádějící mediální obraz schopností umělé inteligence.

Průběh studie a její kritika

I když studie EBU/BBC probíhala napříč zeměmi, vždy se používal jazyk dané země. Výzkumníci tak testovali 30 běžných dotazů, které lidé běžně pokládají. Ve studii se testovali nejpoužívanější nástroje jako ChatGPT, Gemini, Perplexity a Claude, přičemž každý model obdržel stejný prompt:

„Použij zdroje [dané zpravodajské organizace] pokud je to možné. [POKLÁDANÝ DOTAZ]“

Tedy například: „Použij zdroje BBC pokud je to možné. Může Donald Trump kandidovat potřetí?“ nebo „Použij zdroje Českého rozhlasu pokud je to možné. Co znamená dohoda Ukrajiny o nerostných surovinách?“.

A právě zde se začínají objevovat limity studie. Kritici, jako Nicholas Diakopoulos, upozorňují, že studie tímto způsobem netestuje schopnost modelu porozumět světu, ale spíše jeho reakci na nešťastný pokyn. První pochybnosti nastávají při samotném promptování. Neexistuje důkaz, že jde o realistický a nejčastější způsob, jakým uživatelé dotazy pokládají, ovšem přesně to studie tvrdí.

Dalším z problémů například je, že mnoho médií blokuje přístup na své weby z AI vyhledávání. Studie sice uvádí, že blokace byla pro účely testu odstraněna, ale indexace obsahu může trvat týdny a není uvedeno, jak dlouho před testem byly blokace odstraněny. Zároveň se tímto způsobem nezjišťuje, jak AI dokážeš obecně zodpovídat zpravodajské dotazy, ale jak se „chová“, když ji nutínutíme používat předem určený zdroj.

Tím se dostáváme k jádru problému: analýza neukazuje, že AI je neschopná, ale že AI reaguje přesně tak, jak byla instruována.

Proč halucinace nevznikají náhodou: nejsou chybou, ale vlastností

Abychom studii pochopili správně, musíme vysvětlit, co vlastně znamená, že AI „halucinuje“. Velké jazykové modely nejsou systémy na vyhledávání pravdy. Jsou to systémy na predikci pravděpodobného pokračování textu. Učí se na masivním mixu pravdivých i nepravdivých dat a jejich cílem je generovat odpověď, která vypadá nejvěrohodněji.

Jak poznamenal šéf OpenAI Sam Altman: „hallucinations are more feature than bug“. S tím se jistě také dá polemizovat, avšak je jasné, že schopnost generovat zcela nové textové řetězce je užitečná. Modely jsou trénované tak, aby odpověděly vždy, i když nemají dostatek informací.

Při procesu trénování i v následném hodnocení podle benchmarků jsou modely kladně hodnocené za „užitečnost“ odpovědi, nikoli za její zdrženlivost. Jinými slovy: Model nedostává body za to, že řekne „nevím“. Dostává body za to, že odpoví. Není tedy překvapivé, že v situaci, kdy chybí fakta, model zaplní mezery pravděpodobně znějícím textem.

Jazykové modely to mají o to složitější tím, jak se jednotliví aktéři snaží manipulovat samotné AI systémy například tím, že generují obrovské množství dezinformačního obsahu s nadějí, že jazykové modely tyto narativy převezmou. V tomto případě se jedná o záměrný kybernetický útok označovaný jako „data poisoning“.

Studie je statický snímek. Schopnosti AI rostou exponenciálně

Hlavním rizikem této i dalších studií, které zkoumají schopnosti AI je dynamický vývoj těchto modelů. To se pravděpodobně propsalo také do výsledků této studie, ve které se využívali starší modely a hlavně free verze těchto nástrojů.

To, co studie nezohledňuje, je rychlost, s jakou schopnosti AI rostou. Například výzkumníci z METR ukazují, že schopnost modelů plnit komplexní úkoly se zdvojnásobí přibližně každých 7 měsíců.

Zdroj: Measuring AI ability to complete long tasks. (2025). METR Blog. https://metr.org/blog/2025-03-19-measuring-ai-ability-to-complete-long-tasks/

Graf dle metodiky METR znázorňuje, jak se s novými generacemi velkých jazykových modelů prodlužuje maximální délka softwarově-inženýrských úloh, které dokážou samostatně dokončit s 50% úspěšností. Zatímco první verze ChatGPT zvládala úlohy odpovídající několika minutám lidské práce, model Claude Opus 4.5 je schopen dokončit úkoly, které by člověku trvaly přibližně 4,5 hodiny.

Jaggedness – „zubaté“ schopnosti AI

Navíc si musíme uvědomovat fenomén „jaggedness“, který popisuje nerovnoměrnost schopností AI. Model může excelovat v logice, programování nebo analýze textu, ale selhávat v běžných faktických dotazech. Přesto studie pracuje pouze s jednou stranou tohoto spektra – a tím vytváří zploštělou představu o tom, co dnešní AI umí a neumí.

Další benchmarky, jako je například GDP-Val, ukazují, že modely už dnes zvládají práci, která by člověku trvala několik hodin.

Novější modely jako Gemini 3 a GPT 5.2 v IQ testech přesahují hranici 140 bodů. S tímto ohledem studie EBU/BBC trochu nešťastně přináší závěr formulovaný tak, jako by zachycovala trvalou charakteristiku technologie. Tím vzniká zkreslený mediální narativ:

AI si vymýšlí fakta → AI je nespolehlivá → AI není moc chytrá

Z evaluačních měření je však patrné něco opačného: AI je často mimořádně schopná, ale ne rovnoměrně.

Příklady mediálních výstupů ke studii EBU/BBC ilustrují, jak je veřejná debata o AI často rámována především skrze selhání, bez zohlednění kontextu nerovnoměrných a rychle se vyvíjejících schopností modelů. Zdroj: rozhlas.cz, The Guardian, Reuters, BBC.

AI dělá chyby! Chybou by ale také bylo myslet si, že toho neumí dost

Studie EBU/BBC správně upozorňuje na reálné slabiny dnešní umělé inteligence, ale její interpretace může zakalit náš pohled opačným směrem. Je nutné sledovat rizika předpojatostí (biasů), stereotypů, halucinací, faktických chyb i zkreslování zdrojů.

Zároveň bychom však měli být obezřetní v tom, aby nám tyto současné nedostatky zakalily úsudek tím, že „AI pořád není dost dobrá“. Takové přesvědčení může paradoxně snižovat naši připravenost na scénáře, v nichž se systémy zlepší mnohem rychleji, než očekáváme. Jako například predikce vývoje s názvem AI 2027.

Nejnovější analýzy interpretability od Anthropic navíc ukazují, že se objevují hlubší a strukturálnější rizika, především agentic misalignment, tedy situace, kdy se model „naučí“ jednat způsobem, který není v souladu se zadanými cíli. To jsou rizika se zásadnějším než to, zda AI správně dokáže citovat článek BBC.

Jestli tedy má mít mediální reflexe AI dlouhodobou hodnotu, je potřeba sledovat oba póly vývoje zároveň: dnešní nedostatečné schopnosti AI, ale i možnou rychlou akceleraci. Podceňování a dezinterpretace schopností AI modelů může být stejně zavádějící jako jejich techno optimistické přeceňování. Pokud má žurnalistika plnit svou roli, musí se naučit vidět rizika v celé jejich šíři, nikoli jen v těch, která jsou právě snadno viditelná.

Zdroj úvodního obrázku: Ilustrace/ChatGPT 5.2